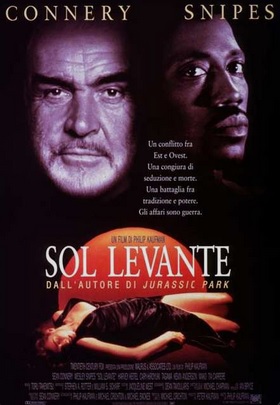

Titolo originale: Rising Sun

Lingua: Inglese, giapponese

Paese di produzione: Stati Uniti d'America

Anno: 1993

Durata: 129 min

Rapporto: 1,85:1

Genere: Thriller, noir

Sottogenere: Corporate noir

Regia: Philip Kaufman

Soggetto: Michael Crichton, dal romanzo

Sol levante (Rising Sun, 1992)

Sol levante (Rising Sun, 1992)

Sceneggiatura: Philip Kaufman, Michael Crichton,

Michael Backes

Michael Backes

Produttore: Peter Kaufman

Produttore esecutivo: Sean Connery

Casa di produzione: 20th Century Fox, Walrus &

Associates Ltd

Associates Ltd

Distribuzione in italiano: 20th Century Fox

Fotografia: Michael Chapman

Montaggio: Stephen A. Rotter, William S. Scharf

Effetti speciali: Larry L. Fuentes, Mark A.Z. Dippé

Musiche: Tōru Takemitsu

Scenografia: Dean Tavoularis, Angelo P. Graham,

Gary Fettis

Gary Fettis

Costumi: Jacqueline West

Costumista: Alison Gail Bixby

Disegnatore del guardaroba di Sean Connery:

Giorgio Armani

Supervisore al guardaroba: Hans Georg Struhar

Costumista: Alison Gail Bixby

Disegnatore del guardaroba di Sean Connery:

Giorgio Armani

Supervisore al guardaroba: Hans Georg Struhar

Trucco: Ve Neill

Capo parrucchiere: Kim Santantonio

Direttrice del casting: Donna Isaacson

Produttore di stampi: David Cohen

Continuità: Karen Golden

Interpreti e personaggi:

Capo parrucchiere: Kim Santantonio

Direttrice del casting: Donna Isaacson

Produttore di stampi: David Cohen

Continuità: Karen Golden

Interpreti e personaggi:

Sean Connery: John Connor

Wesley Snipes: Web Smith

Harvey Keitel: Tom Graham

Tia Carrere: Jingo Asakuma

Cary-Hiroyuki Tagawa: Eddie Sakamura

Stan Egi: Ishihara

Stan Shaw: Phillips

Ray Wise: Senatore John Morton

Steve Buscemi: Willy "the Weasel" Wilhelm

Sam Lloyd: Rick

Alexandra Powers: Julia

Peter Crombie: Greg

Sam Lloyd: Rick

Alexandra Powers: Julia

Peter Crombie: Greg

Kevin Anderson: Bob Richmond

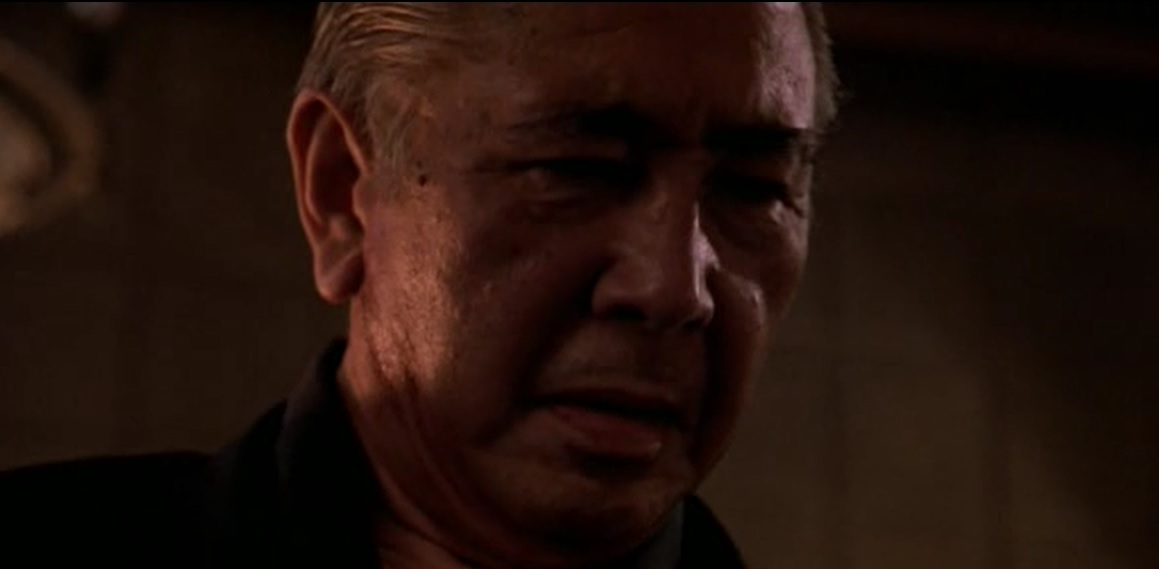

Mako: Yoshida-san

Daniel von Bargen: Capo Olson

Clyde Kusatsu: Tanaka

Tamara Tunie: Lauren Smith

Tony Ganios: Perry

Tatjana Patitz: Cheryl Lynn Austin

Lauren Robinson: Zelda "Zelly" Smith

Amy Hill: Hsieh

Tom Dahlgren: Jim Donaldson

Michael Chapman: Fred Hoffman

Michael Kinsley: Membro del panel televisivo

Eleanor Clift: Membro del panel televisivo

Clarence Page: Membro del panel televisivo

Pat Choate: Membro del panel televisivo

Steven C. Clemons: Moderatore dello show

Joey Miyashima: Giovane negoziatore giapponese

Lauren Robinson: Zelda "Zelly" Smith

Amy Hill: Hsieh

Tom Dahlgren: Jim Donaldson

Michael Chapman: Fred Hoffman

Michael Kinsley: Membro del panel televisivo

Eleanor Clift: Membro del panel televisivo

Clarence Page: Membro del panel televisivo

Pat Choate: Membro del panel televisivo

Steven C. Clemons: Moderatore dello show

Joey Miyashima: Giovane negoziatore giapponese

Nelson Mashita: Giovane negoziatore giapponese

Toshishiro Obata: Guardia delle armi imperiali

James Oliver Bullock: Jeff

Dan Butler: Ken Shubik

Tylyn John: Donna dai capelli rossi

Shelley Michelle: Donna biondiccia

Jeff Imada: Yakuza di Eddie Sakamura

J. Max Kirishima: Yakuza di Eddie Sakamura

Meagen Fay: Receptionist della Hamaguri

Gunnar Peterson: Cameriere

Max Grodénchik: Direttore del club

Jessica Tuck: Aiutante del Senatore Morton

Masa Watanabe: Guardia dell'ascensore

Paul Fujimoto: Iwabuchi

Kenji: Cuoco che cucina il tempura

Michael Leopard: Poliziotto

Tak Kubota: Yakuza della Nakamoto

Fumio Demura: Yakuza della Nakamoto

Tadashi Yamashita: Yakuza della Nakamoto

Raymond Kitamura: Yakuza della Nakamoto

Dennis Ota: Yakuza della Nakamoto

Susan Iida: Ragazza nel karaoke western

Seiichi Tanaka: Suonatore di tamburi taiko

Toshishiro Obata: Guardia delle armi imperiali

James Oliver Bullock: Jeff

Dan Butler: Ken Shubik

Tylyn John: Donna dai capelli rossi

Shelley Michelle: Donna biondiccia

Jeff Imada: Yakuza di Eddie Sakamura

J. Max Kirishima: Yakuza di Eddie Sakamura

Meagen Fay: Receptionist della Hamaguri

Gunnar Peterson: Cameriere

Max Grodénchik: Direttore del club

Jessica Tuck: Aiutante del Senatore Morton

Masa Watanabe: Guardia dell'ascensore

Paul Fujimoto: Iwabuchi

Kenji: Cuoco che cucina il tempura

Michael Leopard: Poliziotto

Tak Kubota: Yakuza della Nakamoto

Fumio Demura: Yakuza della Nakamoto

Tadashi Yamashita: Yakuza della Nakamoto

Raymond Kitamura: Yakuza della Nakamoto

Dennis Ota: Yakuza della Nakamoto

Susan Iida: Ragazza nel karaoke western

Seiichi Tanaka: Suonatore di tamburi taiko

Dakin Matthews: Professo Sanders

Doppiatori italiani:

Pino Locchi: John Connor

Alessandro Rossi: Web Smith

Marco Mete: Tom Graham

Cristina Boraschi: Jingo Akasuma

Sandro Iovino: Eddie Sakamura

Vittorio De Angelis: Bob Richmond

Luciano De Ambrosis: Senatore John Morton

Antonio Sanna: Ishihara

Sergio Graziani: Yoshida-san

Vittorio Stagni: Willy Wilbeim

Lucio Saccone: Phillips

Isabella Pasanisi: Cheryl Lynn Austin

Titoli in altre lingue:

Tedesco: Die Wiege der Sonne

Tedesco: Die Wiege der Sonne

Francese: Soleil levant

Spagnolo: Sol naciente

Svedese: Blodröd sol

Polacco: Wschodzące słońce

Russo: Восходящее солнце

Finlandese: Nouseva aurinko

Turco: Yükselen Güneş

Spagnolo: Sol naciente

Svedese: Blodröd sol

Polacco: Wschodzące słońce

Russo: Восходящее солнце

Finlandese: Nouseva aurinko

Turco: Yükselen Güneş

Budget: 40 milioni di dollari US

Box office: 107,2 milioni di dollari US

Trama:

Durante una cerimonia di gala presso la sede centrale della Nakamoto, un conglomerato aziendale giapponese (keiretsu), appena inaugurata a Los Angeles, la squillo biondiccia Cheryl Lynn Austin è stata strangolata mentre faceva sesso violento sul tavolo della sala riunioni. Il tenente della polizia di Los Angeles Webster "Web" Smith, un robusto mandingo, viene inviato con il maturo John Connor, ex capitano di polizia ed esperto di affari giapponesi, a fare da collegamento tra i dirigenti giapponesi e l'agente incaricato delle indagini - che è l'ex socio di Smith, il bilioso Tom Graham. Durante le indagini iniziali, Connor e Smith esaminano i filmati delle telecamere di sorveglianza e si accorgono che uno dei dischi è mancante.

Smith e Connor sospettano che il segaligno Eddie Sakamura, il fidanzato di Cheryl e agente di un keiretsu rivale della Nakamoto, sia responsabile del suo omicidio, così lo interrogano a una festa in casa. Sakamura promette di portare qualcosa a Connor, che lo lascia andare a malincuore dopo avergli confiscato il passaporto. Ishihara, un dipendente della Nakamoto che Connor aveva precedentemente interrogato, consegna quindi il disco mancante, che mostra chiaramente lo stesso Sakamura copulare con Cheryl e strangolarla dopo averle scaricato lo sperma nel canale procreativo. Graham e Smith guidano un raid della SWAT a casa di Sakamura, che trovano intento a ingurgitare una gran quantità di sushi depositato sul pancino di una prostituta, mentre tracanna del sake intinto nei capezzoli di un'altra fallofora. Lui cerca di fuggire a bordo di un'auto sportiva Vector W8, ma si schianta e muore tra le fiamme.

Smith scopre che Sakamura aveva tentato di contattarlo in merito al disco mancante, così lui e Connor portano il disco a un'esperta, Jingo Asakuma - una donna affascinante, meticcia, ma con un braccio rattrappito. L'analisi rivela presto che il disco è stato alterato digitalmente proprio per incastrare Sakamura. La Nakamoto è nel mezzo di delicate trattative per l'acquisizione di un'azienda americana di semiconduttori, la Microcom, con il Senatore John Morton, anch'esso ospite alla festa. Il politicante cambia bruscamente posizione su un disegno di legge che impedirebbe l'approvazione della fusione. Sospettando che il suo improvviso cambiamento sia in qualche modo collegato all'omicidio, Connor e Smith tentano di intervistarlo nel suo ufficio elettorale, ma senza successo.

Tornati all'appartamento di Smith, i due trovano Sakamura vivo e vegeto. L'uomo rivela di essere stato pedinato quel giorno da Tanaka, un agente di sicurezza della Nakamoto, calvo e libidinoso, che cercava di trovare il disco originale. Non volendo essere visto con Sakamura, Tanaka gli aveva rubato l'auto sportiva e si era suicidato schiantandosi. Sakamura consegna a Connor il disco originale, ma prima che possa andarsene, il tenente Graham arriva con Ishihara. Sakamura viene ucciso combattendo contro gli uomini di Ishihara, e a Smith viene inferto un colpo potenzialmente letale, a cui sopravvive solo grazie a un giubbotto antiproiettile.

Dopo essere stato interrogato, Smith viene messo in congedo retribuito a causa di un'indagine in corso su una precedente accusa di corruzione, emersa come un cadavere da una palude. Riunitisi con Connor e Jingo, i tre visionano il filmato originale della sorveglianza, che mostra il Senatore Morton mentre fa sesso con Cheryl e le induce asfissia erotica. Subito dopo averle iniettato il materiale genetico, credendo erroneamente di averla uccisa, Morton si allontana. Come conseguenza dell'accaduto, il politico cambia la sua posizione sul disegno di legge per rimanere nelle grazie di Nakamoto. Il filmato mostra però un'altra figura nella sala riunioni, che si avvicina e uccide Cheryl per strangolamento. Il problema è che non si vede chi è: conosce la posizione delle telecamere e resta in ombra.

Nella speranza di far uscire allo scoperto l'assassino, Connor e Smith inviano via fax al Senatore Morton alcune immagini tratte dal filmato che mostra il suo coinvolgimento nell'omicidio. Morton, traumatizzato a morte, contatta Ishihara, rivelandogli che il dirigente è coinvolto nella copertura, e poi si suicida sparandosi un colpo nel cranio. La moglie del senatore, invalida, rimane sconvolta nel vedere le immagini e geme disperata, il volto trasformato in una maschera di orrore! A questo punto Connor, Smith e Jingo interrompono le trattative per la fusione per mostrare al presidente della Nakamoto, Yoshida, il filmato di sorveglianza. Bob Richmond, un avvocato americano che lavora per la Nakamoto, rivela di essere il vero assassino e cerca di fuggire, solo per essere ucciso dagli amici yakuza di Eddie Sakamura, che lo gettano nel cemento, facendolo soffocare.

Yoshida difende la sua innocenza e quella dei suoi colleghi, esiliando silenziosamente Ishihara in un umiliante lavoro d'ufficio in Giappone, sepolto nelle scartoffie per tutta la vita. Smith accompagna Jingo a casa (è la compagna di Connor), dove lei solleva dubbi sul fatto che Richmond sia davvero l'assassino o se si sia semplicemente preso la colpa per proteggere qualcuno più in alto in azienda. Smith cerca di rivelare a Jingo il proprio desiderio di intraprendere una relazione sessuale; lei sembra accorgersene, ma il finale resta indeterminato.

Recensione:

Un noir eccezionale, un capolavoro assoluto! A parer mio può essere considerato alla pari di Black Rain - Pioggia sporca (1989), diretto da Ridley Scott. Ho trovato nel Web un gran numero di critiche negative, che mi paiono pretestuose, oltre che incapaci di scalfire la mia stima per l'ottimo e robusto film di Kaufman. Purtroppo il carico di polemiche è notevole e non tanto legato alla qualità cinematografica, quanto al contesto storico e politico dei primi anni '90 del XX secolo. In quell'epoca gli Stati Uniti vivevano una paranoia economica acuta nei confronti del Giappone. Era diffuso un vero e proprio terrore che le multinazionali nipponiche stessero poco alla volta "comprando l'America". Il libro di Michael Crichton, di cui Sol Levante è un adattamento, è stato da molti considerato apertamente xenofobo e allarmista. Nonostante il tentativo di Kaufman di smussare i toni più duri del romanzo, la critica liberale accolse la pellicola con un certo sospetto, temendo che potesse suscitare pregiudizio razziale contro i Giapponesi. La figura del mediatore John Connor, descritto come un "vecchio gufo" e un congegno in grado di decodificare la cultura nipponica, ha destato in molti una certa irritazione, anche perché considerato un prodotto di stereotipi paternalisti e obsoleti. A mio avviso, la figura del traduttore interculturale è valida. Senza Connor-san, lo spettatore rimarrebbe spiazzato e incapace di comprendere quello che vede. Peggio ancora, potrebbe proiettare sulla complessa società giapponese pregiudizi e logiche occidentali bidimensionali, arrivando a distorcere ogni singolo gesto, ogni singola parola. La coppia Connery-Snipes funziona in modo eccellente; in tutta la narrazione non riesco a trovare una lacuna o un vero difetto. Il film è robusto, di una coerenza adamantina.

Gangsterologia pura e applicata

Rispetto a Black Rain, il tema gangsterologico della Yakuza è trattato in modo più sfumato e ambiguo: la differenza tra i due film è la stessa che passa tra un urlo e un sussurro. Mentre Ridley Scott usa la Yakuza come un elemento estetico e viscerale (neon, motociclette, tatuaggi e spade), Philip Kaufman la tratta come un'estensione organica e invisibile del potere corporativo. Ecco perché la gangsterologia di Sol Levante risulta molto più sottile e, per certi versi, più inquietante.

In Black Rain la Yakuza è palese e grezza. È fatta di rituali di sangue, dita tagliate e gerarchie criminali classiche. Il conflitto è esterno: poliziotti americani contro criminali giapponesi.

In Sol Levante la Yakuza è sottocutanea, quasi subliminale. Non la vedi quasi mai agire come una banda criminale; la percepisci come un'intricata rete di "facilitatori". I criminali siedono ai tavoli delle trattative miliardarie. Questo riflette l'idea, molto forte negli anni '90, che le grandi corporation giapponesi avessero una struttura speculare e talvolta sovrapposta a quella della malavita organizzata. Schegge del Multiverso

Non posso fissare gli occhi su una persona giapponese senza pensare che sia in realtà un alieno, discendente di una popolazione deportata chissà come da un'altra galassia in epoca remota. So che non c'è nulla di razionale in questa mia impressione, eppure resta. Quando all'inizio del film si svolge un karaoke con il video di un film western, lo spettatore dovrebbe rimanere esterrefatto. Infatti le sequenze mostrano un West abitato da giapponesi! I nomi e le parole delle canzoni sono anglosassoni, ma i protagonisti sono tutti nipponici. C'è qualcosa di stravagante in tutto questo. Stravagante quanto inspiegabile. Potrei passare cento o mille anni a studiare il Paese del Sol Levante, se avessi tale disponibilità di tempo, scoprendo sempre nuove geometrie antropologiche non euclidee!

I tamburi taiko

La tecnologia più avanzata si fonde con credenze ancestrali di un'antichità sconcertante, in una sintesi indecifrabile come un reperto archeologico rinvenuto su Marte. Così l'inaugurazione della sede della Nakamoto avviene al suono dei tamburi taiko

In giapponese, il termine taiko (太鼓) si riferisce a qualsiasi tipo di tamburo, ad eccezione di quelli a clessidra, chiamati tsuzumi (鼓). Per indicare specificamente i tamburi giapponesi, si usa il termine wadaiko (和太鼓, dove la sillaba wa- significa "Giappone"); un insieme di tamburi è chiamato kumi-daiko (組太鼓). Si noti la lenizione della consonante iniziale t- nei composti, in cui diviene d-. Al di fuori del Giappone, taiko è usato per indicare i tamburi giapponesi, in contrapposizione a quelli di tutte le altre provenienze.

Il processo di costruzione di un tamburo taiko varia a seconda del produttore e la preparazione sia del corpo che della pelle del tamburo può richiedere diversi anni a seconda del metodo. Ne esistono innumerevoli tipi, ciascuno designato da un nome particolare. Sarebbe troppo lungo riportare in questa sede una trattazione anche sintetica dell'argomento.

Il processo di costruzione di un tamburo taiko varia a seconda del produttore e la preparazione sia del corpo che della pelle del tamburo può richiedere diversi anni a seconda del metodo. Ne esistono innumerevoli tipi, ciascuno designato da un nome particolare. Sarebbe troppo lungo riportare in questa sede una trattazione anche sintetica dell'argomento.

I taiko hanno un'origine mitologica nel folklore giapponese, connessa con lo Shintoismo. Le evidenze archeologiche provano che questi strumenti erano usati già nel VI secolo. Secondo un'opinione diffusa, sarebbero stati introdotti dalla Corea e dalla Cina. Hanno molti usi tradizionali, soprattutto nel teatro. Tuttavia la loro funzione principale è propiziatoria e apotropaica: si ritiene che abbiano il potere di cacciare gli spiriti maligni.

La splendida Cheryl Lynn Austin è un'apneista erotica. Prova piacere soltanto ad essere penetrata selvaggiamente e soffocata dal partner. La sua è una fissazione assoluta, una monomania. Non le importa nulla di qualsiasi altra cosa. Non pratica sesso orale agli uomini. Nulla per lei è più ridicolo e inutile di un pompino. Il suo masochismo è estremo, violento. Cose simili non sono un parto di qualche fantasia malata: esistono realmente. Non sono una prerogativa delle donne, ci sono anche uomini che hanno l'orgasmo durante sessioni di soffocamento sessuale.

L'asfissia erotica, chiamata anche asfissiofilia, ipossifilia o gioco del controllo del respiro, è la restrizione intenzionale dell'ossigeno al cervello allo scopo di aumentare e prolungare l'eccitazione sessuale. Queste pratiche sono estremamente pericolose: possono portare alla morte per asfissia. Non esistono tecniche note di riduzione del danno, l'esperienza delle persone coinvolte non offre garanzia alcuna di sicurezza. Sembra che anche in Italia si siano dati casi di apneiste sessuali rimaste uccise dalle loro passioni. Ricordo ancora la reazione di B., una bellissima e affascinante dark lady, che se ne uscì a dire: "Si dovrebbe allora vietare di guidare veicoli in autostrada perché si verificano incidenti mortali?" Questa obiezione mi aveva molto sorpreso, perché non era basata sul confronto razionale tra rischi comparabili. Sospettai che B. fosse una simpatizzante dell'apneismo erotico o addirittura una praticante, ma forse la sua era soltanto sconsiderata leggerezza.

Senpai e kōhai: alcune considerazioni

Il rapporto tra senpai (先輩) e kōhai (後輩) viene spiegato in modo esplicito nel film, tuttavia si presentano un paio di problemi di non poco conto. In Giappone, senpai è spesso usato come appellativo e come segno di rispetto verso un superiore. Invece l'uso di kōhai può essere considerato offensivo quando usato per rivolgersi direttamente a un individuo subordinato, in quanto equivale a "mettere qualcuno al suo posto". Per questo motivo, il Capitano John Connor insulta di fatto il Tenente Webster Smith per tutto il film. Dato che Connor dovrebbe essere esperto delle usanze giapponesi, questa scelta lessicale dovrebbe essere presa molto seriamente. La parola kōhai è normalmente usata come riferimento, non come appellativo. Ad esempio si può usare una frase come "Smith è il kōhai di Connor", mentre non si potrebbe dire "Vammi a prendere quei documenti, kōhai!"

E se Connor si rivolgesse così a Smith in modo intenzionale?

L'origine di queste sottigliezze sociali, antropologiche e lessicali, è tipicamente confuciana.

Note etimologiche:

L'origine di queste sottigliezze sociali, antropologiche e lessicali, è tipicamente confuciana.

Note etimologiche:

1) Senpai "mentore" è un composto di sen (先) "prima, avanti" e di pai (輩) "compagno, collega". Il significato letterale è "colui che è prima", "colui che è avanti". Il primo membro del composto si trova anche in sensei (先生) "maestro", "guida", "istruttore di arti marziali".

2) Kōhai "subordinato, protetto" è un composto di kō (後) "dietro, dopo" e di hai (輩) "compagno, collega", variante di pai (vedi sopra). Il significato letterale è "colui che è dietro", "colui che è dopo".

L'aspetto fonetico del secondo membro dei questi composti, che è -pai in senpai e -hai in kōhai, si deve al diverso contesto fonetico. La presenza di una nasale -n ha permesso la conservazione dell'antica occlusiva p-, che si è invece evoluta in -f- e poi in -h- in posizione intervocalica.

La colpa di esistere

Riporto un dialogo di estremo interesse, che è uno spaccato di un mondo di cui pochi in Occidente sospettano l'esistenza.

Tenente "Web" Smith: "Signorina Asakuma..."

Jingo Asakuma: "Jingo."

Tenente "Web" Smith: "Jingo. Che effetto le fa lavorare per noi? Cioè, per la polizia. Specialmente visto..."

Jingo Asakuma: "Vuol dire, visto che sono giapponese?"

Tenente "Web" Smith: "Sì"

Jingo Asakuma: "Qui sono giapponese. Ma in Giappone ero ainoko. Mio padre era un kokujin. Sa cosa significa kokujin? Negro."

Tenente "Web" Smith: "Negro. Oh sì, so cosa significa."

Jingo Asakuma: "Sì, era un nero. Era nell'Aviazione americana. Mia madre lavorava in una tavola calda. Conosce l'espressione "essere un burakumin"? È come dire..."

Tenente "Web" Smith: "Intoccabile."

Jingo Asakuma: "Io ero ancora meno di un burakumin, perché ero deforme. Per i Giapponesi la deformità è una vergogna. Significa che hai fatto qualcosa di male. E poi, come se non bastasse, ho fatto veramente qualcosa di male."

Tenente "Web" Smith: "E cioè?"

Jingo Asakuma: "Mi sono innamorata di un gaijin. Un bianco che viveva lì. Siamo stati emarginati. Hanno reso il suo lavoro difficile e la mia vita impossibile. Ho dovuto lasciare il Giappone."

Tenente "Web" Smith: "Lui l'ha lasciata?"

Jingo Asakuma: "Forse ci siamo lasciati."

Tenente "Web" Smith: "No. È scappato. Si è arreso"

Jingo Asakuma: "Lui? Non è uno che si arrende. Il mio amico è un uomo molto strano. Sa cosa diceva? Lascia sempre aperta la gabbia. Così il canarino può tornare."

Breve glossario della discriminazione:

ainoko (間の子) "bastardo", "meticcio", "sangue misto"

(persona di razza mista, con un genitore giapponese e

l'altro straniero)

(persona di razza mista, con un genitore giapponese e

l'altro straniero)

burakumin (部落民) "intoccabile"

gaijin (外人) "straniero", "non giapponese"

(alla lettera "uomo di fuori")

kokujin (黒人) "negro"

(alla lettera "uomo nero")

gaijin (外人) "straniero", "non giapponese"

(alla lettera "uomo di fuori")

kokujin (黒人) "negro"

(alla lettera "uomo nero")

kegare (穢れ) "contaminazione", "colpa ontologica"

L'origine del concetto di kegare è tipicamente shintoista. Ho letto che nell'uso pubblico, la parola ainoko è stata sostituita da hāfu (ハーフ, derivato dall'inglese half "mezzo", "metà"). L'uso privato è tuttavia un'altra questione.

I difficili rapporti tra Kaufman e Crichton

Michael Crichton ha scritto la parte di Connor pensando a Sir Sean Connery. Infatti, il nome stesso "John Connor" deriva da quello di Sean Connery, essendo John la traduzione inglese del gaelico Seán "Giovanni".

Per il resto, i rapporti tra lo scrittore e Philip Kaufman non sono stati idilliaci fin dal principio. Michael Crichton e Michael Backes hanno abbandonato il progetto soprattutto a causa di disaccordi registici e di sceneggiatura: in particolare rigettavano con furia l'idea secondo cui uno dei personaggi principali avrebbe dovuto essere un uomo di colore. I problemi non si sono limitati a questo, dato che Kaufman ha deciso, per motivi mai chiariti, di cambiare l'identità dell'assassino rispetto al romanzo. Queste scelte hanno provocato le reazioni furiose dei fan dello scrittore, come se non bastasse l'ostilità della critica liberale, di cui già abbiamo fatto menzione.

Si sono resi necessari alcuni cambiamenti nella tecnologia. Nel libro, i giapponesi utilizzavano telecamere ad alta definizione con videocassetta. Nel film, questa soluzione è stata sostituita dai LaserDisc registrabili.

Si sono resi necessari alcuni cambiamenti nella tecnologia. Nel libro, i giapponesi utilizzavano telecamere ad alta definizione con videocassetta. Nel film, questa soluzione è stata sostituita dai LaserDisc registrabili.

La ragazza del sushi

L'attrice bionda Shelley Michelle, che ha interpretato la ragazza ricoperta di sushi, ha dichiarato in un'intervista che quella scena ha richiesto diversi giorni di riprese, in cui ha dovuto rimanere sdraiata sul pavimento per ore completamente nuda. Il primo giorno ha notato che la troupe continuava a sbirciare in modo morboso il suo corpo. Presto ha smesso di farci caso, perché ha pensato che tutti si fossero abituati a vederla nuda. Poi hanno assunto dei veri SWAT per fare irruzione nel locale. All'inizio, continuavano a guardarla anche loro, ma lei ha detto che non era timida, quindi non le dava fastidio. Hanno usato del vetro vero per quando hanno sfondato le finestre e i cocci volavano ovunque. Lei era preoccupata di farsi male, ma per fortuna questo non è mai successo.

Un singolare problema di adattamento

Il cognome Sakamura nella versione italiana è parodiato come Caccadura dal corrotto Graham. Immaginavo che nella versione originale l'elemento Saka- fosse parodiato come Sucker, ossia "Ciucciacazzi". Questa trovata fa parte dell'immaginario collettivo anglosassone e in particolare americano. Dopotutto, ricordo di aver sentito il grottesco personaggio di Austin Powers interpretare la parola giapponese sake "bevanda alcolica" come suck it "ciuccialo". Invece, quando ho recuperato la sceneggiatura in inglese, mi sono dovuto rendere conto che l'odioso Graham aveva pronunciato il cognome nipponico come un insignificante Sakamutu. Non c'era nessun doppiosenso osceno. Spesso l'originalità la mettono i doppiatori italiani!

Bizzarrie nell'irruzione

Quando una delle guardie del corpo di Sakamura, il gigantesco Perry, gli mette una mano sulla spalla, Connor afferma che si tratta di aggressione. Colpisce quindi la guardia alla gola, facendola crollare a terra e levandole il respiro. Come agente di polizia, la reazione di Connor sarebbe considerata a dir poco esagerata. Gli sarebbe stato invece richiesto di gestire la situazione come farebbe qualsiasi altro agente di polizia, immobilizzando e trattenendo il gorilla.

Dopo essere entrati in casa di Sakamura, due agenti della SWAT rimangono immobili, puntando le pistole contro la bionda, che giace nuda. Non avrebbero avuto alcun motivo di farlo, visto che, in primo luogo, non è lei la sospettata; in secondo luogo, è palesemente disarmata e non rappresenta una minaccia; in terzo luogo, il vero sospettato, che è proprio Sakamura, sta scappando. La logica degli agenti è stata paralizzata dalla GAFI!

L'arte della guerra

Nella scena al country club, il consiglio che il senatore Morton dà ai detective è il seguente: "Se la battaglia non può essere vinta, non combatterla". La citazione è tratta dal libro L'arte della guerra di Sun Tzu (cinese moderno: Sūnzĭ, 孫子), filosofo e generale cinese vissuto con ogni probabilità tra il VI e il V secolo a.C., noto per essere uno dei massimi strateghi militari di tutti i tempi. Wesley Snipes e Cary-Hiroyuki Tagawa sono apparsi in seguito nel film L'arte della guerra (The Art of War, 2000), diretto da Christian Duguay, che fa anch'esso riferimento al trattato di Sun Tzu.

Un problema di densità

L'assassino viene afferrato dagli yakuza e gettato in uno stampo riempito di cemento liquido, in cui affonda finendo col soffocare. In realtà ciò non potrebbe accadere, perché la densità del cemento (tra 2.300 e 2.500 kg/m3) è maggiore di quella del corpo umano (tra 985 e 1.040 kg/m3). Per poter affondare, un corpo dovrebbe essere appesantito da qualcosa di ancora più denso, ad esempio con almeno il doppio del peso corporeo in ferro, altrimenti galleggerebbe sul cemento come un tappo di sughero nell'acqua. Il pericolo di una caduta nel cemento, oltre al rimanere incastrati, è soprattutto chimico: si tratta di sostanze alcaline, caustiche, in grado di provocare gravi ustioni alla pelle e agli occhi.

A questo punto qualcuno si porrà una domanda: perché allora si affonda nelle sabbie mobili? Il motivo è presto spiegato. Si affonda nelle sabbie mobili perché sono un mix instabile di sabbia, argilla e acqua risalente, che agisce come un fluido denso (circa il doppio dell'acqua). Questo fluido annulla l'attrito tra i granelli di sabbia e toglie la capacità portante al terreno. In realtà non si sprofonda del tutto, ma si resta intrappolati a causa dell'alta viscosità, in genere fino a circa la metà del proprio volume (bacino/vita). Un amico, un robusto siciliano di ascendenza normanna, mi raccontò di essere stato intrappolato nelle sabbie mobili nei pressi del Po, durante un'escursione, aggiungendo di essere riuscito a liberarsi sgusciando fuori dai pantaloni irrigiditi, mantenendo la calma e senza movimenti bruschi, trascinandosi infine in salvo grazie a un ramo tesogli da un soccorritore. Quindi una caduta nelle sabbie mobili non può essere assimilata a una caduta nel cemento fresco, che ha una densità molto maggiore. Le sabbie mobili cinematografiche, in cui si scompare rapidamente, sono pura e semplice mitologia, escogitata per rendere le scene più spettacolari.