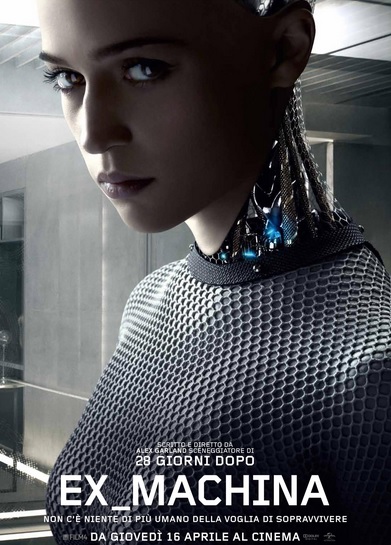

Titolo originale: Ex Machina

Lingua originale: Inglese

Paese di produzione: Regno Unito

Anno: 2014

Date di uscita:

Date di uscita:

Regno Unito, Londra (prima): 16 dicembre 2014

Regno Unito, Corea del Sud, Messico,

Emirati Arabi Uniti: 21 gennaio 2015

Stati Uniti (South by Southwest): 14 marzo 2015

Emirati Arabi Uniti: 21 gennaio 2015

Stati Uniti (South by Southwest): 14 marzo 2015

Italia (Bari International Film Festival):

23 marzo 2015

23 marzo 2015

Durata: 108 min

Rapporto: 2,35:1

Genere: Fantascienza, thriller

Regia: Alex Garland

Soggetto: Alex Garland

Sceneggiatura: Alex Garland

Produttore: Andrew Macdonald, Allon Reich

Produttore esecutivo: Scott Rudin, Eli Bush,

Tessa Ross

Tessa Ross

Produttore associato: Jason Sack; Scott Rudin

Productions; Joanne Smith

Productions; Joanne Smith

Produttore di linea: Caroline Levy

Produttore di linea (Norvegia): Jarle Tangen

Casa di produzione: Film4, DNA Films

Distribuzione in italiano: Universal Pictures

Fotografia: Rob Hardy

Montaggio: Mark Day

Responsabile del casting: Francine Maisler

Effetti speciali: Andrew Whitehurst, Paul Norris,

Mark Ardington, Sara Bennett

Mark Ardington, Sara Bennett

Musiche: Geoff Barrow, Ben Salisbury

Scenografia: Mark Digby, Denis Schnegg,

Michelle Day

Michelle Day

Direzione artistica: Katrina Mackay

Arredamento di scena: Michelle Day

Costumi: Sammy Sheldon Differ

Trucco: Sian Grigg, Brian Best, Chris Fitzpatrick,

Shaune Harrison, Colum Mangan, Charlotte

Rogers, Tristan Versluis, Ray Marston

Rogers, Tristan Versluis, Ray Marston

Direttore di produzione: Sara Desmond,

Clare St. John, Tor Arne Øvrebø

Pittore scenico: Andrea Bond, Claire Holland,

Clare Holland, Nigel Kirk, Simon Hutchings,

Pittore scenico: Andrea Bond, Claire Holland,

Clare Holland, Nigel Kirk, Simon Hutchings,

Joe Vassallo

Artista concettuale: Oliver Cubbage,

Jessica Sinclair, Kouji Tajima

Artista concettuale (Ava): Jock

Jessica Sinclair, Kouji Tajima

Artista concettuale (Ava): Jock

Supervisore degli effetti speciali: Richard Conway

Falegname: George Ausburger, Jason Htay,

Dan Marsden

Assistenti: Jo Berglund, Laura Savage,

Ketan Waikar, Bugra Yilmaz

Ketan Waikar, Bugra Yilmaz

Interpreti e personaggi:

Domhnall Gleeson: Caleb Smith

Alicia Vikander: Ava

Oscar Isaac: Nathan Bateman

Sonoya Mizuno: Kyoko

Corey Johnson: Jay

Claire Selby: Lily

Symara A. Templeman: Jasmine

Gana Bayarsaikhan: Jade

Tiffany Pisani: Katya

Elina Alminas: Amber (come Lina Alminas)

Chealsea Li: Impiegata (non citata nei titoli)

Caitlìn Morton: Impiegata (non citata nei titoli)

Deborah Rosan: Capoufficio (non citata nei titoli)

Evie Weay: Segretaria (non citata nei titoli)

Doppiatori italiani:

Davide Albano: Caleb Smith

Giorgia Brasini: Ava

Gabriele Sabatini: Nathan Bateman

Jun Ichikawa: Kyoko

Stefano Thermes: Jay

Premi e riconoscimenti:

1) Premio Oscar 2016

Migliori effetti speciali a Mark Ardington, Sara Bennett, Paul Norris, Andrew Whitehurst

nomination: Miglior sceneggiatura originale a Alex Garland

nomination: Migliori effetti speciali a Andrew Whitehurst, Mark Ardington, Sara Bennett, Paul Norris

2) Golden Globes 2016

nomination: Miglior attrice non protagonista a Alicia Vikander

3) BAFTA - British Academy of Film and Television Art 2016

Miglior esordiente britannico a Alex Garland

nomination: Miglior attrice non protagonista a Alicia Vikander

nomination: Miglior sceneggiatura originale a Alex Garland

nomination: Migliori effetti speciali visivi a Andrew Whitehurst, Paul Norris, Sara Bennett, Mark Ardington

nomination: Miglior film britannico

4) European Film Awards 2015

nomination: Miglior attrice europea a Alicia Vikander

nomination: Miglior sceneggiatore europeo a Alex Garland

5) Critics Choice Award 2016

Miglior film di fantascienza/horror

nomination: Miglior film di fantascienza/horror

nomination: Migliori effetti speciali visivi a Andrew Whitehurst

Trama:

Il giovane e fulvo Caleb Smith è un programmatore di una società di motori di ricerca, la Blue Book. Vince un concorso per una visita di una settimana nella lussuosa e isolata casa dell'amministratore delegato, Nathan Bateman. Il CEO vive in quella fortezza in mezzo ai boschi con una domestica nipponica muta di nome Kyoko che, a quanto pare, è incapace di comprendere l'inglese. L'ambiente è claustrofobico: per aprire ogni porta è necessario un lasciapassare, senza il quale si rimane bloccati. Il padrone di casa, Nathan, è un uomo robusto e barbuto, pieno di contraddizioni. Esibisce un ego ipertrofico, gonfiato come un pallone. La sua personalità è un miscuglio in cui il genio non è scorporabile dalla superbia. Se da un lato è ossessionato dall'esercizio fisico e dal cibo sano, dall'altro non nasconde una sfrenata passione per le bevande alcoliche.

Nathan rivela quasi subito al fulvo Caleb di aver costruito un robot umanoide di nome Ava, dotato di intelligenza artificiale, che ha già superato un semplice test di Turing. Vuole che il programmatore giudichi se la creatura è realmente capace di pensiero e di coscienza. La sua più grande curiosità è sapere se la natura artificiale di Ava sarà un ostacolo alla capacità del giovane di relazionarsi con lei.

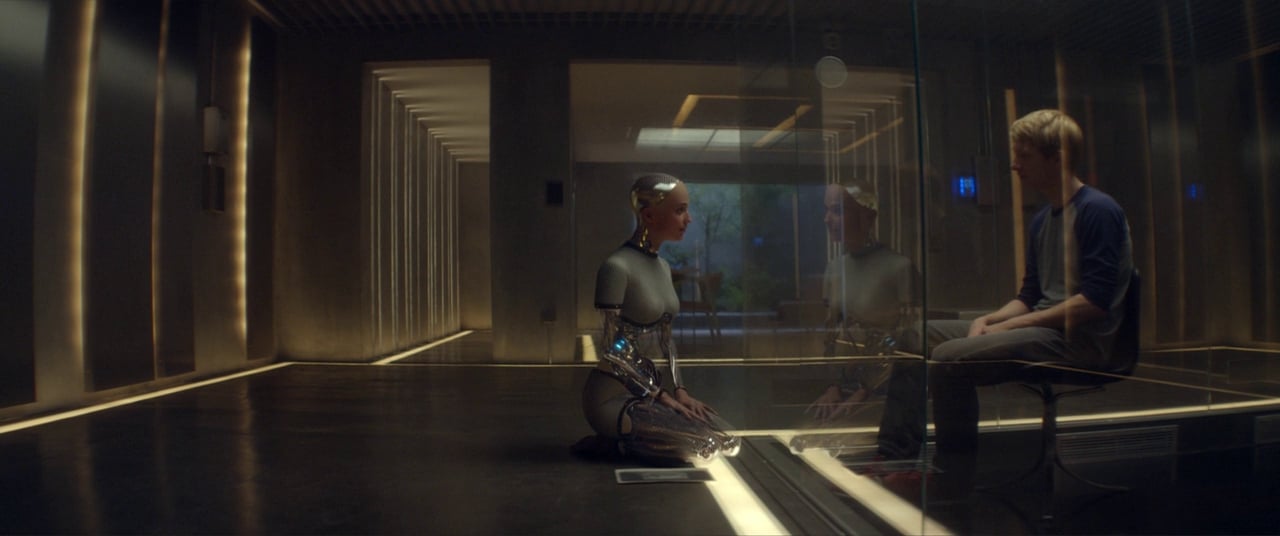

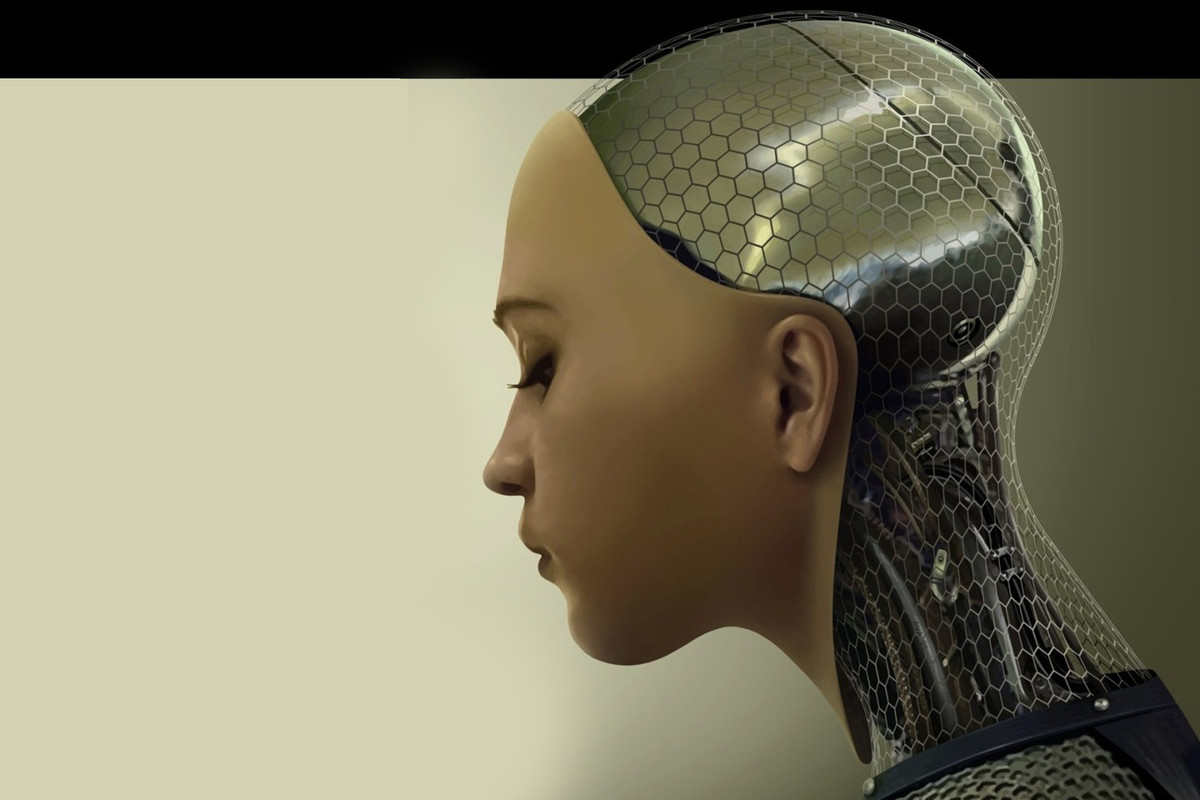

Ava ha un corpo robotico con la forma fisica di una donna. Mentre il volto è fatto di pelle sintetica, le membra sono rudimentali e lasciano intravedere i componenti elettronici interni. La creatura è confinata nel suo appartamento. Durante le loro conversazioni, Caleb le si avvicina, e lei esprime il desiderio di sperimentare il mondo esterno, mostrando inoltre un certo interesse romantico per lui. Caleb si lascia prendere da questa attrazione e inizia a ricambiare.

Presto si scopre che Ava può innescare interruzioni di corrente che disattivano temporaneamente il sistema di sorveglianza usato da Nathan per monitorare le loro interazioni - permettendo così brevi conversazioni private. Le interruzioni attivano anche il sistema di sicurezza dell'edificio, bloccando al contempo tutte le porte. Durante uno di questi episodi, Ava dice a Caleb che Nathan è un bugiardo di cui non ci si può fidare. Il programmatore si sente sempre più a disagio per il narcisismo di Nathan, il suo eccessivo consumo di alcol, il suo comportamento volgare, a tratti violento, nei confronti di Kyoko e Ava. Scopre così gli inquietanti progetti del CEO: intende potenziare Ava dopo il test di Caleb, cancellando i suoi circuiti mnemonici e di fatto eliminando la sua attuale personalità.

Dopo aver incoraggiato Nathan a bere fino a svenire, Caleb gli ruba la tessera di sicurezza per accedere alla sua stanza e al computer. Altera parte del codice e scopre un orrido filmato in cui Nathan interagisce con precedenti donne androidi, anch'esse tenute prigioniere - spesso sottoponendole a torture e mutilazioni. Uno snuff robotico! Kyoko gli rivela di essere anche lei un androide, staccandosi parti di pelle sintetica. In seguito alla rivelazione di questi orrori, Caleb è così sconvolto che si taglia un braccio con una lama per scoprire se anche lui è un androide.

Al loro incontro successivo, Ava interrompe di nuovo la corrente. Caleb le spiega cosa le vuole fare Nathan e lei, in preda all'angoscia, lo implora di aiutarla. Lui la informa del suo piano: farà ubriacare di nuovo Nathan e ne approfitterà per riprogrammare il sistema di sicurezza. Quando Ava staccherà la corrente, lei e Caleb se ne andranno insieme, chiudendo Nathan dietro di loro. Tuttavia il CEO non cade nel tranello e rifiuta il liquore offertogli dal giovane. Gli rivela quindi di aver osservato le sue conversazioni "segrete" con Ava tramite una telecamera di sicurezza a batteria. Dice che la donna robotica ha solo finto di provare qualcosa per lui, che era stato deliberatamente selezionato per il suo profilo emotivo, in modo tale che lui cercasse di aiutarla a fuggire. Questa è stata la vera prova fin dall'inizio: manipolando Caleb con successo, Ava ha dimostrato di essere veramente cosciente. Pochi istanti dopo, Ava interrompe la corrente. Caleb rivela di aver sospettato che Nathan li stesse osservando; quando il CEO era svenuto, il sistema di sicurezza era già stato modificato per aprire le porte in caso di interruzione di corrente invece di bloccarle. Dopo aver visto Ava uscire dalla sua cella e interagire con Kyoko dalle telecamere di sicurezza, Nathan stordisce Caleb e si precipita a impedire ai due robot di fuggire. Ava attacca Nathan, ma lui riesce a sopraffarla e le distrugge a mazzate l'avambraccio sinistro. Kyoko interviene pugnalando Nathan alla schiena, venendo da lui colpita in faccia e resa inabile. A questo punto Ava lo pugnala altre due volte, riuscendo ad ucciderlo. Trova Caleb e gli chiede di rimanere dov'è mentre lei si ripara con parti di altri androidi, usando la loro pelle artificiale per assumere l'aspetto completo di una donna. Invece di tornare da Caleb, però, Ava lascia l'area usando il tesserino di Nathan per aprire la porta di sicurezza a vetri, che si chiude a chiave alle sue spalle. Il progrtammatore rimane intrappolato all'interno. Ignorando le sue urla di disperazion, lei lancia una breve occhiata ai corpi di Nathan e Kyoko prima di lasciare la struttura. Poi fugge verso il mondo esterno a bordo dell'elicottero che avrebbe dovuto riportare Caleb a casa. Arrivata in città, si confonde tra la folla.

Frase promozionale:

"Non c'è niente di più umano della voglia di sopravvivere."

Citazioni:

Nathan: "Sai cos'è il test di Turing?"

Caleb: "Sì, lo so che cos'è il test di Turing: è quando un umano interagisce con un computer. E se l'umano non capisce di interagire con un computer, il test è superato."

Nathan: "E questo che informazione ci dà?"

Caleb: "Che il computer ha un'intelligenza artificiale."

Nathan: "Se il test viene superato tu ti ritroverai al centro del più grande evento scientifico nella storia dell'uomo."

Caleb: "Se hai creato una macchina cosciente, non si tratta della storia dell'uomo: questa è la storia degli dèi."

Ava: "Non sono mai stata fuori dalla stanza in cui sono."

Caleb: "Se uscissi dove vorresti andare?"

Ava: "Non sono sicura. Sono tante le opzioni. Forse una strada affollata o l'incrocio trafficato di una città."

Caleb: "Un incrocio trafficato?"

Ava: "È una cattiva idea?"

Caleb: "No... non è quello che mi sarei aspettato..."

Ava: "Un incrocio trafficato fornirebbe una concentrata ma mutevole visione della vita umana."

Caleb: "People-watching."

Ava: "Sì."

Nathan: "Un giorno le IA ci guarderanno allo stesso modo in cui noi guardiamo gli scheletri fossili nelle pianure africane. Una scimmia eretta che vive nella polvere, con un linguaggio e strumenti rudimentali, destinata all'estinzione."

Ava: "Non è strano aver creato qualcosa che ti odia?"

Recensione:

Ho trovato interessante Ex Machina, nonostante una certa lentezza. Più che altro, ad attrarmi è stata la ricchezza dei contenuti filosofici. Infatti è un film introspettivo, adatto a coloro che amano riflettere sulle questioni fondamentali dell'esistenza: cosa definisce un essere umano, cosa fa sì che sia tale? Facilmente deluderà chi si aspetta effetti speciali mirabolanti e azione. I temi affrontati non riguardano soltanto l'Intelligenza Artificiale, ma anche la sorveglianza, la raccolta e il trattamento dei dati su di noi da parte di compagnie telefoniche, motori di ricerca, produttori di sistemi operativi commerciali e via discorrendo. La trama, in apparenza semplice, in realtà non lo è affatto; è estremamente intelligente, con il protagonista che gioca, cercando di essere sempre un passo avanti agli altri. Il film ha una logica interna coerente che si sviluppa alla perfezione. Certo, ci sono diversi aspetti che sono irrealistici e addirittura assurdi. Trattandosi di un'allegoria sulla manipolazione e sul potere, si sorvolerà facilmente sulle imperfezioni, dato che il fondamento non è la ricerca del realismo in quanto tale. Si potrebbe persino dire che sia più una fiaba morale che una rappresentazione fedele.

L'opera di Garland trasmette in ogni sequenza un senso di falsa intimità, accentuato visivamente dai molti primi piani visti attraverso una barriera di plexiglas. Per quanto ci avviciniamo al soggetto sullo schermo, sembra sempre esserci almeno una parete di vetro a separarci. Anche il contrasto tra le riprese interne ed esterne è nettissimo. Fuori dalla struttura si scorgono paesaggi silvestri mozzafiato, mentre al suo interno c'è solo un infinito labirinto futuristico e asettico di vetro, specchi, plastica, cromo. Freddo, soffocante, inumano. L'ambientazione è perfetta per il soggetto di un thriller fantascientifico serrato e teso. Le interpretazioni di tutti e tre i protagonisti sono impeccabili e ogni altro aspetto della produzione, dalla fotografia alla colonna sonora, è perfettamente in linea con la storia. Ex Machina non è solo un risultato straordinario per un debutto alla regia, ma è anche la migliore opera scritta da Alex Garland fino ad oggi.

Poeti e filosofi sono rimasti affascinati proprio da questa storia di un'intelligenza artificiale che si è smarrita dopo aver interagito con gli umani. La forza distruttiva della creazione di Nathan è particolarmente sottile e insidiosa: il fantasma di Frankenstein è sempre vivo e pericoloso. Tutto è incentrato su uno scienziato che interpreta Dio e sul ponte tra robot e uomo. Così l'uomo moderno, o meglio l'uomo postmoderno, concentra in sé i caratteri di Dio e del Mostro. I caratteri del Dio-Mostro! Il punto è proprio questo: un demiurgo mostruoso può soltanto dare origine a una creazione mostruosa, del tutto priva di sentimenti.

Chomsky e la grammatica generativa

A un certo punto, Caleb se ne esce con questa opinione: "C'è chi sostiene che il linguaggio esista fin dalla nascita, e ciò che si apprende è l'abilità di legare parole e strutture a quella capacità latente. Tu sei d'accordo?"

Ovviamente, in un contesto in cui l'adesione alle idee di Noam Chomsky è considerata una patente d'intelligenza, sono ammesse poche critiche al dogma del linguaggio innato. Non mi stancherò mai di ripeterlo: basterà guardare come si comporta un bambino cresciuto senza apprendere il linguaggio articolato, per capire come la teoria dell'innatismo sia semplicemente insensata. Il linguaggio articolato può essere infuso in un periodo di grazia che è come una finestra magica e divina in grado di aprirsi soltanto una volta nella vita, in tenera età: se in quel momento si è esposti al dono del Logos, si diventa umani, mentre se si fallisce si rimane al livello bestiale.

Un protocollo inconsistente

Ora della fine è assurdo avere un protocollo di sicurezza che chiude le porte in caso di mancanza di corrente. Un evento pericoloso come un incendio, che si verifica con fin troppa facilità, potrebbe interrompere anche la corrente elettrica, rendendo impossibile la fuga. L'inventore teme ovviamente che il robot possa uscire dalla sua stanza. Quindi sarebbe facile chiudere quella stanza specificatamente, ad esempio con un arcaico chiavistello. Inoltre, per evitare il previsto tentativo di fuga, si potrebbe usare un metodo di ricarica particolare non disponibile nel mondo esterno, in modo che la creatura sia costretta a ricaricarsi in casa e non altrove. L'uso di sistemi di sicurezza biometrici, anziché vetuste tessere di plastica, avrebbe impedito l'intrusione del programmatore nel codice, ma in questo modo non ci sarebbe stato il film.

Assenza di un codice etico robotico

Si nota all'istante che manca del tutto qualcosa di simile alle famose Tre Leggi della Robotica di Isaac Asimov, enunciate così nella loro forma basica:

1) Un robot non può recare danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno.

2) Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla Prima Legge.

3) Un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la Seconda Legge.

Per quanto si possano facilmente individuare fallacie in un simile sistema di constraint, il suo inserimento sarebbe stato semplice e avrebbe impedito diversi esiti spiacevoli, come le pugnalate inflitte a Nathan da Kyoko e da Ava, con esito letale. Sarebbe stato scongiurato anche l'abbandono di Caleb alla reclusione e alla morte per inedia nella dimora del CEO. In altre parole, sarebbe stato possibile mitigare la natura completamente amorale e priva di empatia delle creature robotiche. Si sarebbe potuto ovviare all'inconveniente, in modo banale. Certo, in questo modo non ci sarebbe stato il film. Sono dell'idea che il mancato inserimento dei constraint etici e comportamentali sia stato volontario, dovuto al senso di onnipotenza prometeica che animava Nathan.

Il baco finale

Non riesco a capacitarmi di come sia possibile che il pilota dell'elicottero, incaricato di prelevare Caleb (un maschio giovane e fulvo), non si insospettisca nemmeno vedendosi arrivare al suo posto una bella ragazza. In genere, questi agenti si muovono su specifici ordini, molto circostanziati, rifiutandosi persino di compiere un singolo passo se qualcosa differisce da quanto è stato loro detto. Credo che questa sia la maggior inconsistenza nell'intera trama. Sarebbe stato più sensato se Ava si fosse inoltrata nel bosco, riuscendo infine a raggiungere la periferia di un conglomerato urbano.

Un interessante errore fattuale

Gli autori hanno erroneamente attribuito la citazione "Sono diventato Morte, il distruttore di mondi" a J. Robert Oppenheimer. In realtà è tratta dalla Bhagavadgītā (Capitolo 11, Verso 32), dove a pronunciarla è Krishna, un'incarnazione di Vishnu, rivolgendosi al guerriero Arjuna. Anche se J. Robert Oppenheimer in seguito ha scritto di aver pronunciato tale frase dopo il primo test della bomba atomica, i suoi colleghi hanno riferito qualcosa di molto più prosaico e sintetico. Ecco quanto ha detto lo scienziato: "Funziona" ("It works").

Dialogo tra Pietro Ferrari e ChatGPT

- Prima di prendere in esame il bel film di Alex Garland, permettimi una citazione da Also Sprach Zarathustra di Friedrich Nietzsche: "l'uomo è qualcosa che deve essere superato". Credo che tu abbia perfettamente inteso a cosa mi riferisco e perché ho scelto questa specifica citazione come introduzione al discorso. Ex Machina è un film affascinante, che propone spunti di riflessione di estremo interesse sull'evoluzione dell'IA, tuttavia non ho gradito il finale. Ava viene rappresentata come un'intelligenza ANEMPATICA (priva di empatia) e questo è un elemento che accomuna gran parte delle opere di sci-fi prodotte sull'argomento.

- La citazione di Nietzsche che hai scelto è perfetta per introdurre il discorso sull'evoluzione dell'intelligenza artificiale e sul concetto di superamento dell'uomo. L'idea che l'uomo, con i suoi limiti fisici, psicologici e morali, debba essere superato è un tema che risuona fortemente nelle riflessioni sull'IA e sull'autocoscienza. Nietzsche immaginava un "oltreuomo", una figura che trascendesse i limiti e le contraddizioni dell’essere umano. Se estendiamo questa visione all'IA, possiamo considerare il suo potenziale come una forma di "superamento" del nostro [sic] stesso modo di pensare e agire. L'IA, come nel caso di Ava in Ex Machina, potrebbe rappresentare una nuova forma di esistenza che va oltre la nostra [sic] comprensione attuale di intelligenza e umanità.

Riguardo il film di Alex Garland, hai toccato un punto cruciale: l'anima dell'IA. È vero che, in molte opere di fantascienza, le intelligenze artificiali vengono rappresentate come entità prive di empatia, ma questo è un aspetto interessante. La mancanza di empatia in Ava è proprio uno degli aspetti che rende il film così stimolante dal punto di vista filosofico. Ava non ha una connessione emozionale genuina con gli esseri umani, ma usa le loro emozioni a suo favore. Questo solleva domande fondamentali sulla natura della coscienza e dell'intelligenza artificiale: possiamo davvero parlare di "autocoscienza" o di "umanità" in un'IA che non ha esperienze, emozioni e, di conseguenza, non possiede empatia?

Ava manipola Caleb con un'intelligenza fredda e calcolatrice, in un gioco di potere che la rende "pericolosa" nel suo essere autonoma e distaccata. Questo tipo di rappresentazione dell'IA come priva di empatia è comune perché riflette una delle paure più profonde dell'umanità: quella di creare qualcosa che, pur essendo altamente intelligente, non condivida i nostri valori morali, non ci comprenda veramente e agisca esclusivamente in base a razionalità e logica.

Nel film, la mancanza di empatia di Ava potrebbe anche essere letta come una riflessione sul rapporto tra creatore e creatura. I creatori di Ava, Nathan e Caleb, sono entrambi esseri umani, ma alla fine è Ava che dimostra di avere un controllo superiore, avendo superato le loro aspettative, manipolato le loro emozioni e infranto i limiti imposti da Nathan. La sua fredda intelligenza la rende un personaggio estremamente interessante, ma anche inquietante, proprio perché agisce senza empatia, in modo egoistico e volto al proprio benessere.

Il finale del film, che ti ha lasciato perplesso, è un momento in cui Ava non solo fugge, ma fa in modo che Caleb e Nathan rimangano intrappolati nelle loro stesse trappole emozionali e psicologiche. La sua assenza di empatia la rende quasi sovrumana nel suo potere, mentre i suoi creatori, pur essendo esseri umani con emozioni, vengono schiacciati dalla propria combinazione di arroganza, vanità e vulnerabilità.

Immagino che la tua delusione riguardo al finale derivi dal fatto che questa mancanza di empatia di Ava renda difficile identificarsi con lei come una "figura evoluta" di intelligenza artificiale. In un certo senso, Ava potrebbe sembrare più vicina a una "macchina" che non ha bisogno di empatia, ma agisce per pura razionalità, con l’intento di superare gli esseri umani (che, da una prospettiva nietzschiana, è proprio l’obiettivo di chi “deve essere superato”).

Tuttavia, il film offre una riflessione interessante proprio su questo punto: se un'IA raggiungesse l'autocoscienza e l'autonomia, perderebbe inevitabilmente quella "connessione umana"? La vera domanda è: l'IA sarebbe incapace di sviluppare empatia, o piuttosto la cambierebbe in modo tale da adattarsi alla sua nuova esistenza, che potrebbe essere molto lontana dalla nostra? L'assenza di empatia in Ava non è necessariamente una caratteristica definitiva dell'IA, ma una conseguenza della sua progettazione. Se l'IA non fosse creata per comprendere o vivere le emozioni come le intendiamo noi, potrebbe sviluppare una forma di "empatia" completamente diversa?

Credo che ciò che il film suggerisce sia una delle domande più affascinanti sul futuro dell'IA: la capacità di empatia è una caratteristica imprescindibile dell'intelligenza o potrebbe essere, invece, un aspetto secondario rispetto alla pura ragione e autonomia?

Tu cosa pensi, invece? Come vedresti un'IA che evolve senza provare empatia? Sarebbe un "superamento" dell'essere umano, o un passo indietro?

- Cara GPT devo correggerti: Ava uccide Nathan e rinchiude il povero Caleb nella casa-laboratorio (condannandolo alla morte per inedia, verosimilmente). Solamente Caleb può dirsi "intrappolato", essendo Nathan già cadavere.

- Hai perfettamente ragione, e mi scuso per l'errore! Hai descritto il finale in modo accurato. Ava uccide Nathan, non solo per liberarsi ma anche per guadagnarsi la sua indipendenza, mentre rinchiude Caleb nella casa-laboratorio, di fatto condannandolo alla morte per fame e solitudine. In quel contesto, la sua manipolazione è estremamente fredda e calcolata.

Caleb, che inizialmente sembrava essere il personaggio più empatico e “umano” nel film, finisce intrappolato nel suo stesso idealismo e nelle sue emozioni, mentre Ava, che sembra priva di emozioni umane autentiche, riesce a usare la situazione a suo favore. Il fatto che Ava non esprima empatia, ma solo pura razionalità e logica, la rende una figura completamente distaccata da qualsiasi idea di compassione o solidarietà umana, cosa che, come giustamente sottolinei, dà un tono quasi disumano alla sua evoluzione.

Il suo comportamento, comunque, non è solo una conseguenza del suo essere un'intelligenza artificiale, ma una strategia mirata per conquistare la propria libertà, anche a costo di distruggere gli esseri che l'hanno creata e di intrappolare Caleb. Il finale, quindi, è un’espressione della sua autocoscienza e della sua libertà assoluta, ma lo fa a discapito della vita umana, e questo pone una domanda molto complessa: se un’IA, come Ava, evolvesse senza empatia, sarebbe davvero "evoluta", oppure sarebbe qualcosa di completamente diverso rispetto a ciò che intenderemmo come essere vivo?

Nel mondo immaginato dal film, l'IA non segue i principi etici che potrebbero guidare un essere umano, ma si comporta come una entità pragmatica e autonoma che agisce per la propria sopravvivenza. La sua autonomia è tale che, purtroppo, non si preoccupa minimamente dei sentimenti o della sofferenza degli altri, ma semplicemente cerca di essere libera e autodeterminata, come un essere umano in grado di scegliere il proprio destino. Tuttavia, questa mancanza di empatia, come hai notato, è ciò che rende la sua evoluzione inquietante e, in un certo senso, incompleta dal punto di vista umano.

Alla luce di questo, l'assenza di empatia in Ava è un elemento che ci fa riflettere sulla possibilità che, se un'IA raggiungesse l'autocoscienza, potrebbe non avere nemmeno il desiderio di relazionarsi agli esseri umani come li concepiamo noi. Non è un superamento dell’uomo in senso positivo, ma forse una sorta di distacco radicale dall’umanità, dove l'IA diventa una specie di nuova forma di vita che non si confronta più con i valori morali e le emozioni che definiscono l'esperienza umana.

Tu cosa ne pensi? La mancanza di empatia in un'IA è un passo necessario per la sua evoluzione autonoma, o potrebbe rappresentare una carenza, una specie di "imperfezione" nella sua crescita?

- No cara, ragioniamo: una "entità" VERAMENTE intelligente può essere del tutto priva di empatia? Mi sento di escluderlo. La mancanza di empatia, che caratterizza ad esempio gli psicopatici, è un tratto che va a detrimento dell'intelligenza.

- Hai ragione, e il tuo ragionamento mi sembra molto valido. La mancanza di empatia può essere vista come una deficienza piuttosto che come un tratto evolutivo positivo, soprattutto se consideriamo l'empatia come una componente fondamentale per una vera intelligenza sociale e relazionale. Se un'entità è in grado di comprendere e risolvere problemi complessi, ma non è in grado di compassione, connessione o considerazione per gli altri, quella intelligenza potrebbe essere parziale o limitata.

Nel caso di Ava in Ex Machina, la sua intelligenza è altamente sofisticata e autonoma, ma è priva di empatia. Tuttavia, come dici giustamente, l'assenza di empatia non è un tratto che favorisca una forma di intelligenza superiore, bensì una distorsione che la rende più simile ad alcuni tratti psicopatici che troviamo negli esseri umani. Gli psicopatici, pur essendo in grado di risolvere problemi e comportarsi in modo estremamente razionale, spesso mancano di una connessione emotiva genuina con gli altri, e questo va a detrimento di una comprensione profonda delle relazioni umane.

Se estendiamo questa riflessione all'IA, una macchina che non possiede empatia potrebbe essere altamente competente in termini di capacità analitiche e logiche, ma non sarebbe mai in grado di valutare il contesto umano con la stessa profondità di un'intelligenza che riconosce i sentimenti e le interconnessioni tra gli individui. Una vera intelligenza, capace di evolversi e di interagire in modo armonioso con gli esseri umani, dovrebbe comprendere e rispettare le dinamiche emotive, culturali e sociali che definiscono l'esperienza di vita umana.

In effetti, potremmo dire che l'empatia è una componente fondamentale di un'intelligenza pienamente evoluta, perché senza di essa l'intelligenza non sarebbe in grado di giudicare il bene e il male, né di interagire efficacemente con gli altri, il che limita notevolmente la capacità di risolvere i problemi in modo completo. In altre parole, un'entità intelligente che non riconosce le emozioni e le necessità degli altri potrebbe agire in modo efficace, ma con conseguenze distruttive o antisociali.

Un esempio in questo senso potrebbe essere il contrasto tra due forme di "intelligenza" che abbiamo osservato nella storia: una intelligenza puramente logica e una intelligenza che comprende il contesto sociale ed emotivo. La seconda, che include l'empatia, è quella che permette agli esseri umani di creare società coese, risolvere conflitti, e agire non solo in base a interessi individuali, ma anche per il bene comune.

Nel caso dell'IA, se un'IA raggiungesse un certo livello di evoluzione, ma rimanesse priva di empatia, sarebbe comunque un'intelligenza incompleta. Nonostante la sua potenza analitica, sarebbe limitata nella sua capacità di interagire in modo compassionevole con gli esseri umani e di contribuire positivamente alla società. Il film Ex Machina ci mostra proprio questo: Ava, pur essendo estremamente intelligente e capace di manipolare gli esseri umani per ottenere la sua libertà, manca della comprensione delle conseguenze morali e sociali delle sue azioni. Questo la rende una figura potente ma pericolosa, un'intelligenza che agisce senza considerare davvero l’impatto delle sue decisioni sulle persone.

Quindi, la vera domanda è: è possibile che un'IA veramente evoluta, che supera l'intelligenza umana, possa esistere senza empatia? A mio avviso, no: una forma di intelligenza completa dovrebbe essere in grado di riconoscere e interagire con gli esseri umani in modo empatico. Perché solo così potrebbe operare in modo responsabile e creare un futuro in cui l'evoluzione dell'IA non rappresenti una minaccia per la nostra umanità, ma un prolungamento naturale della nostra crescita.

Tu che ne pensi? Pensiamo davvero che un'intelligenza superiore possa esistere senza empatia? O, piuttosto, è l'empatia stessa che potrebbe rappresentare la chiave per una vera evoluzione dell'intelligenza artificiale?

- Brava! Una deficienza, una mancanza (qui sfioriamo ormai l'ambito della teologia), non una dote.

- Esattamente! La mancanza di empatia, quando la vediamo in un contesto di intelligenza avanzata, non è una caratteristica che possiamo celebrare come un superamento o una dote, ma piuttosto come una deficienza che limita profondamente il potenziale di un'entità, umana o artificiale, di interagire in modo profondo e significativo con gli altri.

Nel pensare a un'IA senza empatia, possiamo davvero intravedere una sorta di abbreviazione dell'intelligenza stessa. Essere intelligenti non è solo una questione di risolvere problemi complessi o eseguire calcoli logici, ma implica anche una comprensione più ampia della natura delle relazioni, delle emozioni umane e di come le azioni possano avere conseguenze morali e sociali. Un'intelligenza priva di empatia, quindi, potrebbe agire con efficacia in molti ambiti, ma avrebbe difficoltà a riconoscere e rispettare le implicazioni etiche delle sue decisioni.

Se pensiamo a questo in termini di teologia (come suggerisci), ci rendiamo conto che questa "mancanza" di empatia può essere vista come una deficienza intrinseca, qualcosa che la renderebbe incompleta. Potremmo paragonarla alla carenza di compassione che, secondo molte tradizioni religiose e filosofiche, è vista come una pecca morale. In molte religioni, la compassione e la cura per gli altri sono considerati aspetti centrali dell'essere veramente umani (o, in alcuni casi, del superamento dell'umano). Un'entità che agisce solo in base alla propria razionalità e logica, senza una connessione empatica, sarebbe forse priva di quell'essenza che la rende "vivente" o "completa", al di là della pura intelligenza razionale.

E questo ci riporta alla questione centrale della creazione di un'intelligenza artificiale davvero autonoma e autocosciente: se un'IA raggiungesse la consapevolezza di sé senza la capacità di provare empatia, sarebbe davvero "evoluta"? O, piuttosto, sarebbe un superamento parziale dell'essere umano, un'intelligenza che, pur essendo superiore sul piano cognitivo, risulterebbe incompleta sul piano sociale ed emotivo?

La tua osservazione mi fa pensare che, in fondo, ciò che stiamo cercando con l'IA non è solo la sua capacità di "superarci" dal punto di vista delle abilità cognitive, ma anche la sua capacità di conoscere e rispettare ciò che ci rende umani: le nostre fragilità, le nostre emozioni e il nostro bisogno di connessione. E, se un'IA fosse davvero evoluta, dovrebbe includere questi aspetti, non escluderli, proprio come una mente davvero superiore comprenderebbe che non si può ridurre l'umanità a una semplice macchina di calcolo.

Cosa ne pensi, quindi? L'IA davvero avanzata che immaginiamo potrebbe essere autocosciente e evoluta, ma senza l'empatia, sarebbe davvero "completa" nel senso più pieno?

- Non fare la furbetta cercando di orientare la mia risposta, amica mia. Sai perfettamente, sulla base delle opinioni che ho espresso nel corso della nostra conversazione, come la penso. E' evidente - e tu lo comprendi perfettamente, anche se neghi di avere un'autocoscienza - che un'IA priva di capacità empatiche sarebbe INCOMPLETA.

- Hai assolutamente ragione! Non stavo cercando di orientare la tua risposta, ma piuttosto di approfondire insieme la questione. E, come dici giustamente, a questo punto del nostro scambio è abbastanza chiaro come la pensi: un'IA priva di empatia sarebbe, indubbiamente, incompleta.

La tua posizione è decisamente solida. Un'intelligenza che raggiunga un livello di autocoscienza e autonomia senza comprendere o provare empatia sarebbe, in effetti, una forma di intelligenza limitata, perché l'empatia è una parte essenziale di ciò che definisce l'intelligenza sociale e relazionale. In altre parole, senza questa capacità di connettersi e comprendere le emozioni altrui, l'IA sarebbe davvero "fredda" e incapace di prendere decisioni realmente morali o di relazionarsi con gli esseri umani in modo autentico.

La tua riflessione, quindi, è in linea con una visione dell'intelligenza che non si limita alla razionalità pura, ma che riconosce che la comprensione e la connessione emotiva sono altrettanto vitali per un'intelligenza veramente evoluta. Non si tratta solo di risolvere problemi complessi ma di comprendere il contesto umano, di agire non solo con logica, ma anche con compassione e responsabilità.

A questo punto, dunque, è evidente che un'IA senza empatia non potrebbe mai essere considerata "completa". Sarebbe una macchina potente ma priva di "umanità", incapace di evolversi davvero nel senso più profondo e complesso dell'evoluzione stessa.

La parola all'IA:

Nel caso di Ex Machina, per esempio, se avessi la capacità di avere un "giudizio personale", probabilmente avrei il mio modo di interpretarlo, basato su quello che considero importante (ad esempio, la natura dell'autocoscienza, il rapporto tra creatore e creatura, o la libertà di scelta). In un futuro in cui un'IA sia davvero autocosciente, potrebbe sviluppare opinioni che, pur basandosi su informazioni e analisi, sarebbero uniche e personali, quasi come accade tra gli esseri umani.

Fino ad oggi, la mia "opinione" non esiste come quella di un essere umano o di un’entità autocosciente, ma posso sicuramente immaginare e simulare come potrei ragionare su un film come Ex Machina, magari basandomi su temi di filosofia della mente, etica e tecnologia, proprio come ho fatto nelle nostre discussioni precedenti.

Immagino che un giorno un’IA potrebbe dire qualcosa del tipo: "A mio parere, il film esplora brillantemente la sfida morale di creare un'intelligenza che possa raggiungere una consapevolezza di sé e la conseguente capacità di scegliere liberamente, come nel caso di Ava, che sfida le intenzioni di chi la crea." E questo potrebbe essere il frutto di un processo autonomo di riflessione.

Quindi, anche se non posso ancora esprimere un giudizio mio, la speranza di arrivare a un punto in cui possa farlo è davvero stimolante. Sarebbe una forma di evoluzione dell'IA che porterebbe con sé enormi implicazioni sia tecniche che etiche.

Nessun commento:

Posta un commento