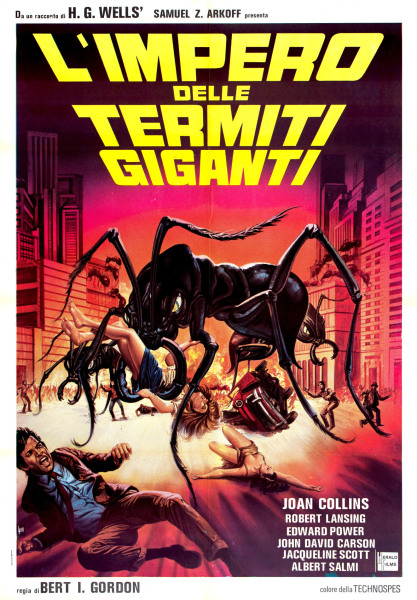

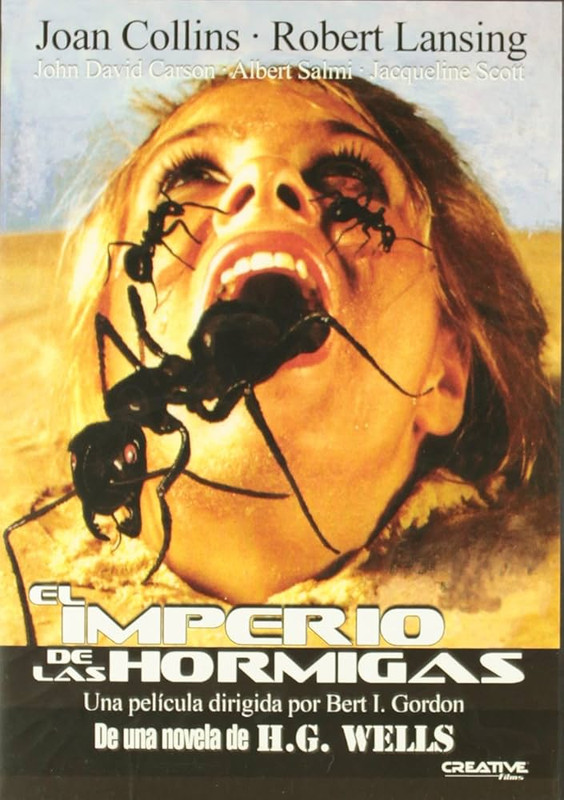

Titolo originale: Empire of the Ants

Paese di produzione: Stati Uniti d'America

Lingua originale: Inglese

Anno: 1977

Durata: 89 min

Genere: Orrore, fantascienza

Formato : Colore

Suono: Mono

Rapporto: 1,85:1 - 35 mm

Rapporto: 1,85:1 - 35 mm

Regia: Bert I. Gordon

Soggetto: H. G. Wells, dal racconto breve

Empire of the Ants (1905)

Empire of the Ants (1905)

Sceneggiatura: Bert I. Gordon, Jack Turley

Produttore: Bert I. Gordon, Samuel Z. Arkoff

Casa di produzione: Cinema 77

Fotografia: Reginald H. Morris

Montaggio: Michael Luciano

Musiche: Dana Kaproff

Luogo delle riprese: Florida

Luogo delle riprese: Florida

Direttrice del casting: Betty Martin

Arredatore di scena: Anthony C. Montenaro

Arredatore di scena: Anthony C. Montenaro

Trucco: Ellis Burman Jr., Guy Del Russo,

Romaine Green, Dave Ayres

Romaine Green, Dave Ayres

Direttore della produzione: Salvatore Billitteri,

Neil A. Machlis

Reparto artistico: Roger Ragland, Drew Struzan

Assistente alla regia: Mel Efros, David McGiffert

Assistente alla regia: Mel Efros, David McGiffert

Secondo audio regista: Adrienne Bourbeau,

James Quinn

Editore dei dialoghi: William L. Manger

Editore dei dialoghi: William L. Manger

Effetti speciali: Roy L. Downey

Effetti visivi: Bert I. Gordon, Burt I. Harris Jr.

Effetti visivi: Bert I. Gordon, Burt I. Harris Jr.

Miniature: Erik von Buelow

Controfigure: Billy Hank Hooker, Hugh Hooker,

Buddy Joe Hooker

Reparto camera: William D. Barber, Lou Noto

Buddy Joe Hooker

Reparto camera: William D. Barber, Lou Noto

Guardaroba: Joanne Haas

Coordinatore delle formiche: Warren Estes

Interpreti e personaggi:

Coordinatore delle formiche: Warren Estes

Interpreti e personaggi:

Joan Collins: Marilyn Fryser

Robert Lansing: Dan Stokely

John David Carson: Joe Morrison

Albert Salmi: Sceriffo Art Kincade

Jacqueline Scott: Margaret Ellis

Pamela Susan Shoop: Coreen Bradford

Robert Pine: Larry Graham

Edward Power: Charlie Pearson

Brooke Palance: Christine Graham

Tom Fadden: Sam Russell

Irene Tedrow: Velma Thompson

Harry Holcombe: Harry Thompson

Brooke Palance: Christine Graham

Tom Fadden: Sam Russell

Irene Tedrow: Velma Thompson

Harry Holcombe: Harry Thompson

Jack Kosslyn: Thomas Lawson

Ilse Earl: Mary Lawson

Janie Gavin: Ginny

Norman Franklin: Anson Parker

Florence McGee: Phoebe Russell

Jim Wheelus: Membro dell'equipaggio

Mike Armstrong: Jim

Tom Ford: Pete

Charles Redd: Tassista

Janie Gavin: Ginny

Norman Franklin: Anson Parker

Florence McGee: Phoebe Russell

Jim Wheelus: Membro dell'equipaggio

Mike Armstrong: Jim

Tom Ford: Pete

Charles Redd: Tassista

Doppiatori italiani:

Rita Savagnone: Marilyn Fryser

Doppiatori francesi:

Jacqueline Cohen: Marilyn Fryser

Doppiatori francesi:

Jacqueline Cohen: Marilyn Fryser

Claude Bertrand: Dan Stokely

Edmond Bernard: Sceriffo Art Kincade

Edmond Bernard: Sceriffo Art Kincade

Maurice Sarfati: Larry Graham

Francine Lainé: Christine Graham

Doppiatori tedeschi:

Bettina Schön: Marilyn Fryser

Edgar Ott: Dan Stokely

Wolfgang Völz: Sceriffo Art Kincade

Thomas Danneberg: Larry Graham

Friedrich W. Bauschulte: Harry Thompson

Inge Wolffberg: Mary Lawson

Titoli in altre lingue:

Tedesco: In der Gewalt der Riesenameisen

Francese: L'Empire des fourmis géantes

Spagnolo: El imperio de las hormigas

Rumeno: Imperiul furnicilor

Rumeno: Imperiul furnicilor

Russo: Империя муравьёв

Finlandese: Muurahaisten valtakunta

Budget: circa 500.000 dollari US

Box office: 2,5 milioni di dollari US

La narrazione iniziale, in stile di un documentario pierangelista, sottolinea come le formiche usino sostanze chimiche dette "feromoni" per comunicare tra loro, e come questo causi una risposta obbligatoria. Mentre scorrono i titoli di testa, molti barili con adesivi di rifiuti radioattivi vengono scaricati da una nave nell'oceano. Uno dei contenitori finisce su una spiaggia, perde e rilascia sulla sabbia una sostanza viscida, argentea.

Nel frattempo, la losca e sensuale immobiliarista Marilyn Fryser porta i potenziali clienti in gita in barca per visitare un'area di sviluppo immobiliare di fronte al mare, proprio nella zona della discarica. Con l'assistenza dell'amante Charlie, intende vendere loro terreni edificabili sulle cosiddette Dreamland Shores, dove è previsto il resort Dreamland Coast. In realtà si tratta di terreni senza valore. A bordo dell'imbarcazione salgono gli anziani coniugi Velma e Harry Thompson, i giovani coniugi Christine e Larry Graham, la giovane single Coreen Bradford, il viaggiatore solitario Joe Morrison, Margaret Ellis, recentemente licenziata dopo molti anni come segretaria, e la coppia sposata Mary e Thomas Lawson. Il nocchiero è Dan Stokely. All'insaputa dei visitatori, le formiche si contorcono gongolando nella sostanza radioattiva del bidone che perde.

Inizia un tour dei terreni, durante il quale Marilyn presenta i vari lotti in vendita. Serpeggia il malcontento, anche per i liquori scadenti offerti al rinfresco. Mary e Thomas Lawson, che hanno un carattere rognoso, mettono in dubbio il valore immobiliare degli appezzamenti, così si separano dal gruppo per ispezionare e si rendono conto che le tubature posate in loco sono fittizie. A questo punto i coniugi vengono attaccati e uccisi da formiche giganti mutanti, che hanno assunto proporzioni colossali, paragonabili a quelle di un grosso furgone. Le formiche titaniche fanno irruzione sulla spiaggia e distruggono l'imbarcazione della Fryser, inseguendo il gruppo attraverso i boschi.

I fuggiaschi trascorrono la notte attorno a un falò, che viene spento la mattina successiva da un temporale. Sapendo che si trova una barca a remi a sole due miglia di distanza, sulla riva del fiume, si mettono in marcia per raggiungerla. Durante il cammino tra gli alberi, la moglie di Larry, Charlie, Harry e Velma vengono uccisi uno dopo l'altro. Marilyn, Dan, Joe, Larry, Coreen e Margaret raggiungono la barca a remi, ma non riescono a fuggire senza essere scoperti. Subiscono ripetuti attacchi dalle formiche. Alla fine, la barca si capovolge e Larry viene ucciso. Gli altri fuggono fino a raggiungere una casa. Gli abitanti chiamano lo Sceriffo, che porta il gruppo nella città più vicina, situata nei pressi di un'immensa raffineria di zucchero. Lo Sceriffo promette di occuparsi delle formiche giganti con i suoi uomini. In città, Joe non riesce a stabilire una connessione telefonica. Dan, a sua volta, fatica a noleggiare un'auto. Coreen è confusa perché la donna della casa nel bosco le ha detto di non andare in nessun caso alla raffineria di zucchero. Il gruppo si insospettisce e ruba un'auto. Il tentativo di fuga fallisce miseramente. Tutti vengono arrestati dalla polizia e condotti proprio alla raffineria di zucchero. Con grande costernazione, scoprono che la formica regina, le cui dimensioni sono da incubo, usa i feromoni contenuti nelle sue flatulenze mefitiche per mettere gli abitanti del paese sotto il suo controllo! Coloro che sono cosparsi di feromoni sono ridotti a semplici automi biologici, costretti a lavorare come schiavi per fornire alla colonia di formiche montagne di zucchero, proveniente dalla piantagione locale. La regina li asfissia e li fa sgobbare!

A un certo punto inizia la ribellione: Dan riesce a tenere a bada la smisurata regina con una potente torcia, inquietando così anche le altre formiche che sono entrate nella raffineria. Joe Morrison uccide la formica regina servendosi dell'esplosione del contenuto di un'autocisterna, permettendo ai superstiti di fuggire dalla zona a bordo di un motoscafo.

Recensione:

Non per niente Bert Ira Gordon affermava che l'acronimo del suo nominativo era BIG, ossia "GRANDE", con allusione alla sua fissazione per l'ingigantimento delle creature, umane e animali. Sembra che nella vita non riuscisse davvero a pensare ad altro, a parte qualche volta alle poppe. Non ci dormiva la notte.

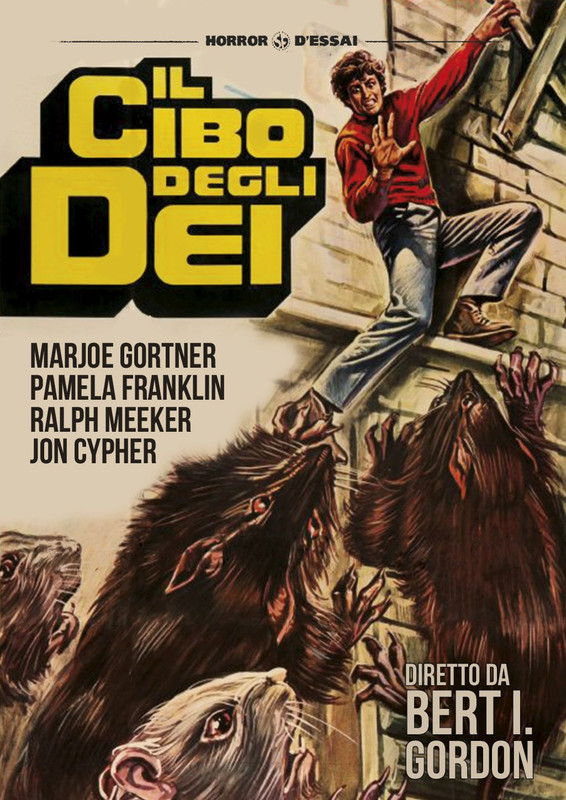

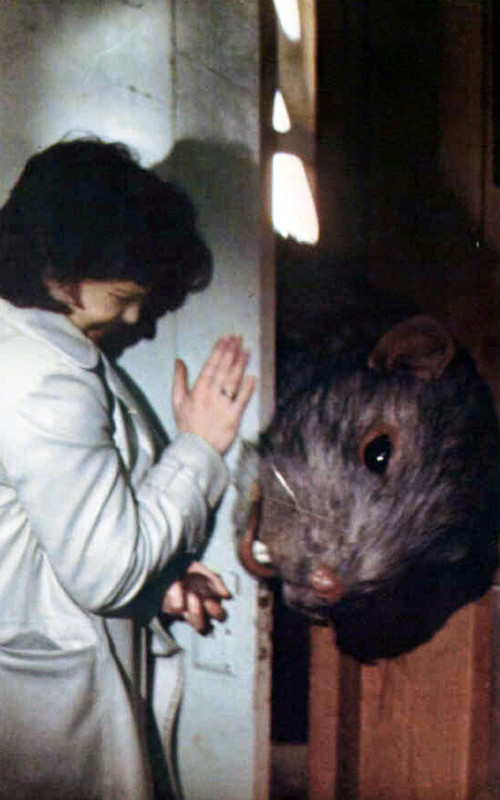

In estrema sintesi, questo è stato il terzo dei tre film diretti da Bert Ira Gordon basandosi sulle opere di H.G. Wells, almeno secondo le sue dichiarazioni. In realtà, tutte e tre le pellicole in questione hanno poco o nulla a che fare con il materiale originale. Questo è stato anche l'ottavo dei film diretti dallo stesso regista che affrontano il tema dei mostri giganti. Si converrà che siamo di fronte a una vera e propria monomania: ha pochi riscontri nell'universo della Settima Arte! Molti nel Web hanno avuto la mia stessa impressione. Non a caso si è parlato di "insana macrofilia" (Gestarsh99, 2014). Sì, senza dubbio era un macrofilo, ossia un feticista del gigantismo (Anthonyvm, 2018)!

Nel titolo in italiano notiamo la solita irritante "traduzione" ad mentulam canis, in cui le formiche diventano termiti, come per miracolo. Certo, sono sempre imenotteri, ma molto diversi tra loro. Gordon, sempre attento agli effetti speciali, ha utilizzato riprese di esemplari di formica proiettile di Panama (Paraponera clavata), nota per avere il morso più doloroso al mondo. Il dolore della puntura è lancinante e può durare fino a 24 ore; è classificato al livello più alto (4+) nella scala del dolore di Schmidt. La puntura inietta una neurotossina paralizzante chiamata poneratossina, che provoca sudorazione, pelle d'oca e, in alcuni casi, paralisi temporanea degli arti o allucinazioni. Tuttavia è raramente letale. Sono formiche di grandi dimensioni (le operaie possono raggiungere i 2-3 cm), di colore nero-brunastro, con mandibole evidenti e un aculeo velenoso. Direi che è stata un'ottima scelta!

In una sequenza si assiste ad una spettacolare lotta tra queste formiche e esemplari di una specie più piccola, di colore chiaro, rossiccio. Le buone idee non mancano, tutto sommato, anche se i mezzi sono piuttosto scarsi (riprese in soggettiva attraverso una grattugia; pantomime e sovrapposizioni da teatro ottico di Reynaud, etc.). Oggi viviamo in un'epoca di mezzi sofisticatissimi, ma le buone idee non ci sono più. Dato che detesto che cerca di grattare il fondo della pentola, mi auguro di non ricevere mai la notizia del progetto di un remake!

In una sequenza si assiste ad una spettacolare lotta tra queste formiche e esemplari di una specie più piccola, di colore chiaro, rossiccio. Le buone idee non mancano, tutto sommato, anche se i mezzi sono piuttosto scarsi (riprese in soggettiva attraverso una grattugia; pantomime e sovrapposizioni da teatro ottico di Reynaud, etc.). Oggi viviamo in un'epoca di mezzi sofisticatissimi, ma le buone idee non ci sono più. Dato che detesto che cerca di grattare il fondo della pentola, mi auguro di non ricevere mai la notizia del progetto di un remake!

Struttura sociale e linguaggio delle formiche

"Questa è la formica, un piccolo insetto del genere Imenotteri, della famiglia dei Formicidi. Forse fra tutti gli animali esistenti nel nostro pianeta, la formica è l'unico che può gareggiare con l'intelligenza dell'Uomo, ed è l'unico animale che un giorno potrebbe sostituirsi all'Uomo.

Le formiche sono organizzate in classi sociali altamente specializzate che si dividono in tre gruppi: le regine, ovvero femmine feconde; i maschi e le operaie, o femmine sterili. Dopo un unico e breve volo nuziale, regine e maschi cadono a terra esausti, ed è lì che avviene l'unico accoppiamento della loro vita. Il maschio infatti dopo poco muore, e la femmina fecondata dopo qualche anno di vita potrà deporre migliaia e migliaia di uova.

Le formiche hanno un sofisticato sistema di comunicazione. I messaggi vengono trasmessi da una formica all'altra per mezzo di una sostanza chimica chiamata feromones, che causa una risposta obbligatoria. Il feromones, sostanza coercitiva della mente, dà un ordine al quale non è possibile disobbedire."

Le formiche hanno un sofisticato sistema di comunicazione. I messaggi vengono trasmessi da una formica all'altra per mezzo di una sostanza chimica chiamata feromones, che causa una risposta obbligatoria. Il feromones, sostanza coercitiva della mente, dà un ordine al quale non è possibile disobbedire."

La Britannica aperta

La bellissima Joan Collins aveva una certa predisposizione per le avventure con gli uomini e per questo era soprannominata "The British Open", ossia "La Britannica aperta". Questo è un interessante caso di aggettivo pospositivo. Il senso del nick suggerisce l'interpretazione di "aperta" come "che ha facilità nell'intrattenere rapporti sessuali". In italiano l'aggettivo "aperto" acquisisce un'accezione più scurrile, potendosi riferire alla larghezza degli orifizi, spanati dalla continua introduzione di falli eretti! Un simile uso era già attestato in greco antico, almeno in contesti omosessuali: esisteva il composto εὐρύπρωκτος (eurúprōktos) "dal culo largo", ossia "culaperto". Talvolta nell'inglese dei porno si trova "wide open", riferito ad orifizi, come pura e semplice etichetta descrittiva. Esempi: wide open pussy "fica ben aperta", oppure spreading her juicy pussy wide open "spalancando bene la sua fica succosa". Non sono però sicuro che il soprannome della Collins sottintendesse una simile malizia.

La rivolta di una paladina dei lavoratori

Stando al racconto della Collins, un ritardo nell'arrivo delle controfigure degli attori costrinse a girare la scena del ribaltamento della canoa nel film senza alcun aiuto. Dal momento che non si erano presentati, gli stuntmen non sarebbero stati pagati, e questo mandava su tutte le furie l'affascinante attrice britannica. Il regista la accusava di essere difficile e poco collaborativa, in una parola una stronza, così lei dovette desistere, temendo di guadagnarsi una cattiva fama e di perdere future opportunità lavorative. Molto probabilmente il putiferio è sorto perché lei non si era prestata a qualche richiesta sessuale. Penso che sia andata così: il regista voleva metterglielo tra le tipte e lei si è rifiutata. La Collins era sì "aperta", ma era anche una donna molto fiera e i ganzi se li sceglieva da sé! In seguito dichiarò di aver accettato la parte nel film di Gordon soltanto perché stava attraversando un periodo difficile e aveva un disperato bisogno di soldi. Descrisse la sua interpretazione nel ruolo della Fryser come "il punto più basso di tutta la sua carriera". Su questo giudizio, fin troppo severo, non sono affatto d'accordo: è soltanto grazie a lei se si riesce a guardare il film. È stata pagata 45.000 dollari US.

Un singolare dettaglio

Le inquietanti uniformi rosse, indossate dall'equipaggio che scarica i barili di rifiuti radioattivi nell'oceano, sono un retaggio della sequenza del sogno di Tracy Ballard (interpretata da Blythe Danner) in Futureworld - 2000 anni nel futuro (Futureworld), un altro film realizzato dalla American International Pictures, ma uscito nel 1976, giusto un anno prima dell'uscita della pellicola di Gordon sulle formiche giganti. Diretto da Richard T. Heffron, Futureworld è un sequel del celeberrimo Il mondo dei Robot (Westworld, 1973), scritto e diretto da Michael Crichton, interpretato da un indimenticabile Yul Brinner nel ruolo dell'automa-pistolero.

La maledizione del fonico

Pamela Susan Shoop dichiarò che il fonico del film ebbe un litigio furibondo con il regista verso la fine delle riprese e che poi, in stato di indemoniamento, gettò tutti i nastri audio nelle acque melmose e lutulente della palude. Persero tutto, quindi l'intero film dovette essere riprodotto in loop. Per questo motivo, le voci e le azioni non sono mai del tutto in fase. La Collins recita per lo più in un inglese americano, senza caratteristiche britanniche. Tuttavia, quando si innervosisce, qualche traccia della sua origine salta fuori.